1. 최적화 개념

딥러닝 분야에서 최적화란 손실함수 값을 최소화하는 파라미터를 구하는 과정.

딥러닝에서는 학습데이터를 입력해서 네트워크 구조를 거쳐 예측 값(y^)을 얻음

이 예측 값과 실제 정답을 비교하는 함수가 손실함수, 즉 모델이 예측한 값과 실제값 차이를 최소화하는 네트워크 구조의 파라미터를 찾는 과정이 최적화

2. 기울기 개념

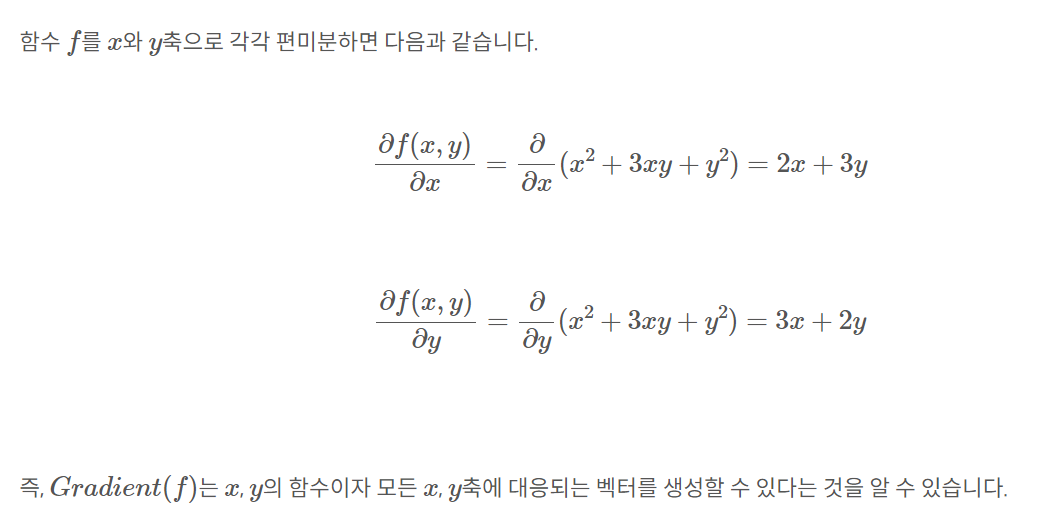

경사 하강법을 알아보기 전에 기울기를 먼저 이해하고 넘어가야 됨. 기울기란 미분 가능한 N개의 다변수 함수 f를 각 축이 가리키는 방향마다 편미분 한 것

2. 경사 하강법 개념

경사 하강법이란 딥러닝 알고리즘 학습시 사용되는 최적화 방법 중 하나

딥러닝 알고리즘 학습 시 목표는 예측값과 정답값 차이인 손실 함수의 크기를 최소화 시키는 파라미터를 찾는 것

학습데이터의 입력을 변경할 수 없기에 손실 함수 값의 변화에 따라 가중치, 혹은 편향을 업데이트 해야함,

그럼 어떻게 최적의 가중치나 편향을 찾을 수 있을까요?

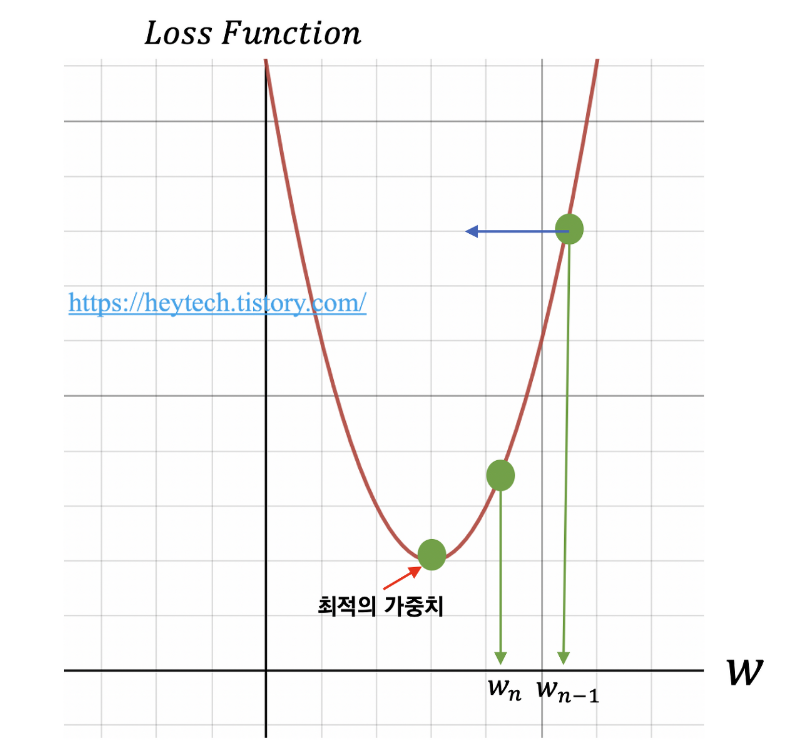

그 과정은 다음과 같습니다. 가로 축은 가중치를 세로축은 손실 함수를 의미, 먼저 임의의 가중치를 선정

예를 들어 w_n-1 을 선택했다고 했을 때 최적의 가중치를 찾기 위해서 목표함수인 손실함수를 w에 대해 편미분 하고 이를 학습률(learning_rate)와 곱한 값을 앞서 선정한 w_n-1에서 뺴줍니다

위 수식을 통해 손실 함수의 값이 거의 변하지 않을 때까지(약 10−6) 가중치를 업데이트하는 과정을 반복합니다. 이처럼 손실 함수 그래프에서 값이 가장 낮은 지점으로(=손실 함수의 최솟값) 경사를 타고 하강하는 기법을 경사 하강법이라고 부릅니다.

4. 경사 하강법의 한계

경사 하강법은 크게 2가지 한계점이 있습니다.

- 첫째, Local Minimum에 빠지기 쉽다는 점

- 둘째, 안장점(Saddle point)을 벗어나지 못한다는 점

- https://heytech.tistory.com/380

'Deep Learning' 카테고리의 다른 글

| Sigmoid vs Softmax (1) | 2023.11.01 |

|---|---|

| 퍼셉트론 개념 (0) | 2023.09.22 |

| 손실함수 , 활성함수 정리 (0) | 2023.09.06 |

| Embedding layer와 Embedding Vector의 Output 차이 정리 (0) | 2023.02.14 |

| Embedding Vector 과정 및 정의 (0) | 2022.11.19 |