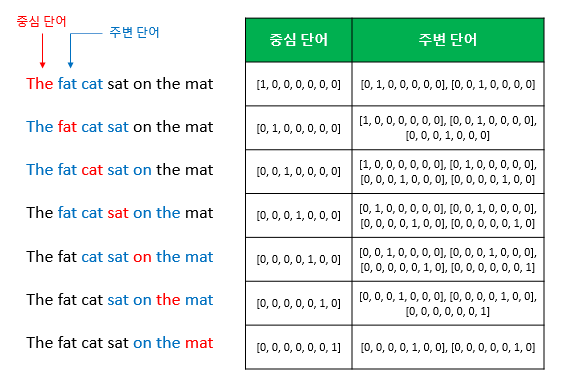

* 협업 필터링 (Collaborative Filtering) 협업 필터링은 어떤 특정한 인물 A가 한가지 이슈에 관해서 인물 B와 같은 의견을 갖는다면 다른 이슈에 대해서도 비슷한 의견을 가질 확률이 높을 것 Memory-based 협업 필터링의 추천 시스템은 유사도를 기반으로 동작 Movie Lense Dataset 1. ratings.dat 2. movies.dat -> 위의 두가지의 데이터셋을 통해 Rating Matrix를 만드는 것이 목표 Object : 특정 시간 이전에 시청했던 영화들을 통해 앞으로 어떤 영화를 볼 지 예측하는 것 user = 7명 (u) 영화 = 5개 (i) 7*5=35개의 총 평가지표(유저 x 아이템) ->1번 유저가 보지않은 2번과 5번 등 아직 빈칸이 있는 곳을 예측..