학습 매개변수 - a,b가 조금식 달라짐

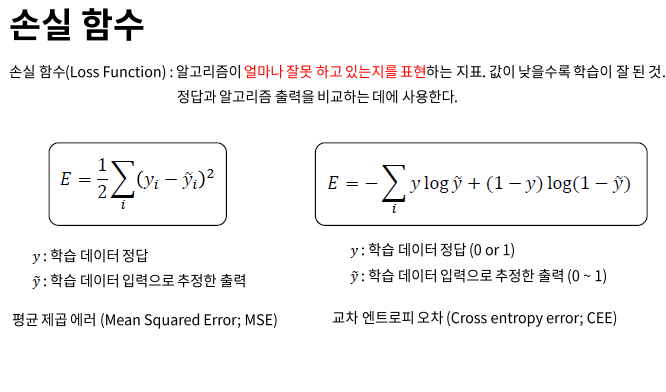

손실함수(lost function, cost function)의 예 : MSE (평균제곱에러) , Cross entropy error (교차엔트로피 오차)

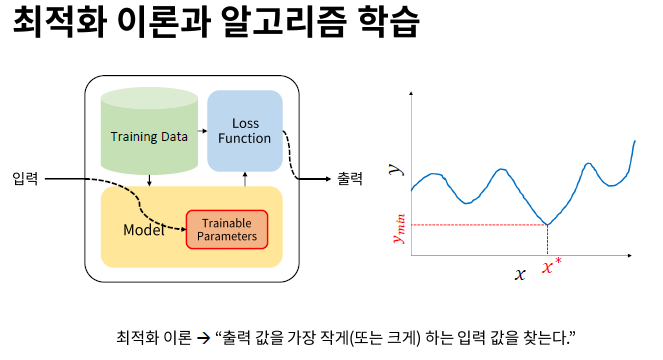

가능한 모든 수를 대입해서 출력 값을 확인해보는 것 - 여러문제들로인해 실제 사용 불가

이렇게 많이 대입하는 것이 아니라 적게 대입하고 최적값을 찾을 수는 없을까? 해서 나온게 Gradient Descent

GD는

1.시작점은 랜덤하게 정해줘야함

2. 사진의 시작점을 미분하면 음수가 나왔기에 왼쪽으로 가면 더 내려가겠구나를 알 수있음

3. 왼쪽으로 내려가다보면 경사하강법을 통해 최저값을 알아 낼 수 있음

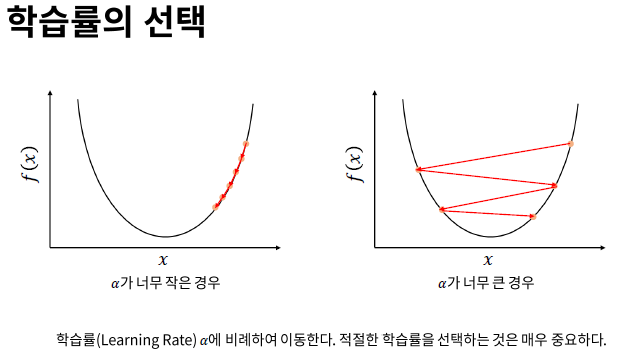

학습률(learning rate,a) , (a * 기울기) 해서 이동함

그래서 학습률 a 가 너무작거나 크지않고 적절 해야함

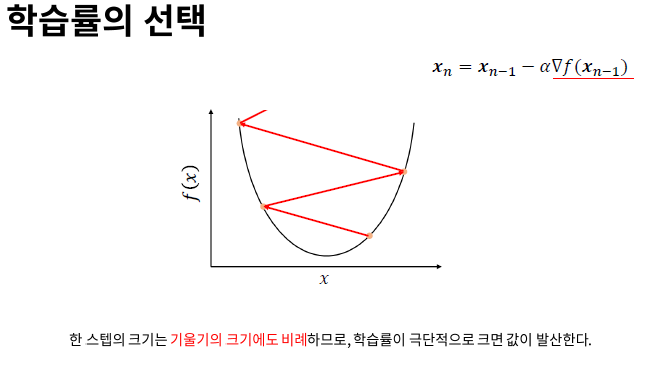

이동하는 방향이 왼쪽이면 -a 를 곱함

이동하는 방향이 오른쪽이면 +a 를 곱함

학습률 learning rate , a 가 극단적으로 크면 무한대(inf)로 발산함 -> 그러면 곧 x값이 정의가 되지않아 Nan으로 바뀜

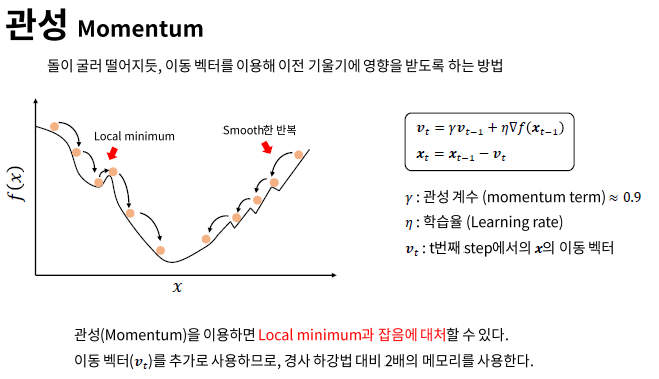

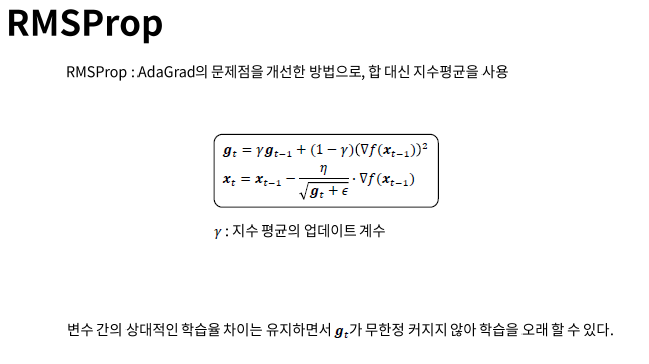

Gradient descent 외의 방법들

반응형

'Deep Learning' 카테고리의 다른 글

| BERT의 학습 원리 및 transferlearning (0) | 2021.04.14 |

|---|---|

| keras - Image generator (0) | 2020.11.27 |

| 전통 데이터마이닝 vs 딥러닝 (0) | 2020.10.04 |

| Hypothesis, Cost, Loss Function (0) | 2020.08.30 |

| LDA -linear Discriminant Analysis (0) | 2020.06.26 |